1次元信号である音は、2次元信号である画像に比べて情報量が少なく、一見すると理解しやすいようにも思えるのですが、じつは、理系の大学でも、音について正しく理解している学生はそれほど多くないように感じます。音は目に見えないことが、理解を阻むハードルになっているのかもしれません。

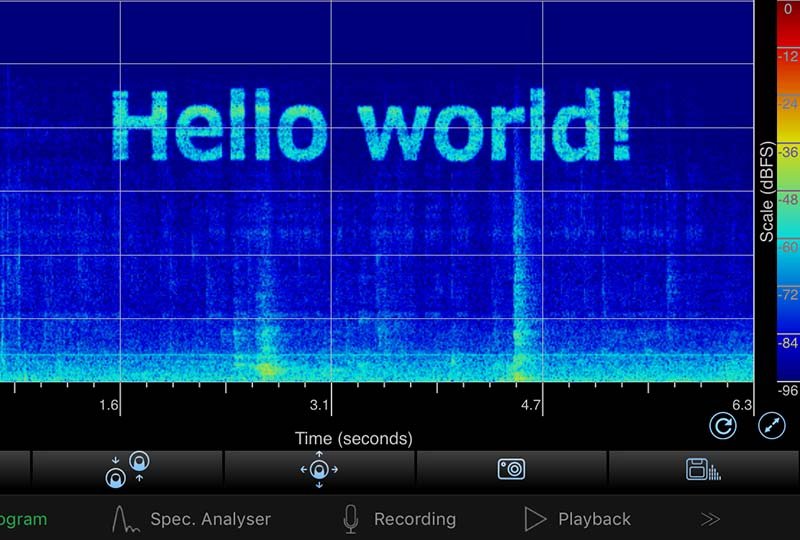

逆に、目で見ることで理解しやすくなるのであれば、何とかして音を可視化すればよいということになるわけですが、じつは、そのためのツールとして音響学の専門家が最も頼りにしているのがスペクトログラムです。スペクトログラムは、横軸を時間、縦軸を周波数として、周波数特性の時間変化を濃淡表示したものになっています。

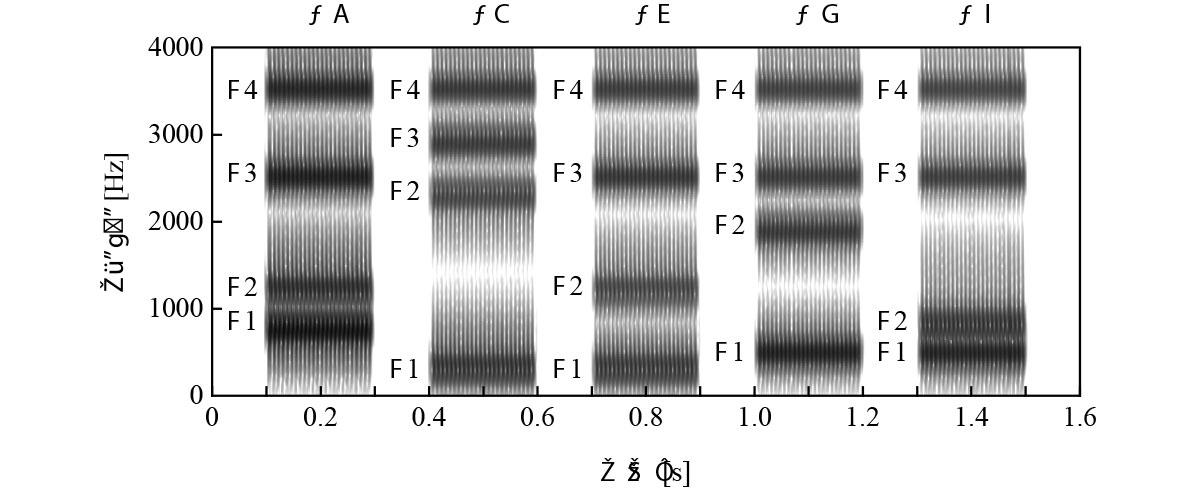

実際にスペクトログラムをながめてみましょう。図1は、日本語の5母音をそれぞれ0.2秒ずつ発声したときの音声のスペクトログラムです。

図1 5母音のスペクトログラム

山の高さを濃淡表示する普通の地図と同様、スペクトログラムは、周波数特性における山の高さを濃淡表示したものになっています。前々回のレポートでは、日本語の5母音を識別するための手がかりとしてフォルマントについて説明しましたが、図1と図2を見比べてみるとおわかりのように、周波数特性における山の部分にあたるフォルマントは、スペクトルグラムでは黒い帯のように表示されることになります。

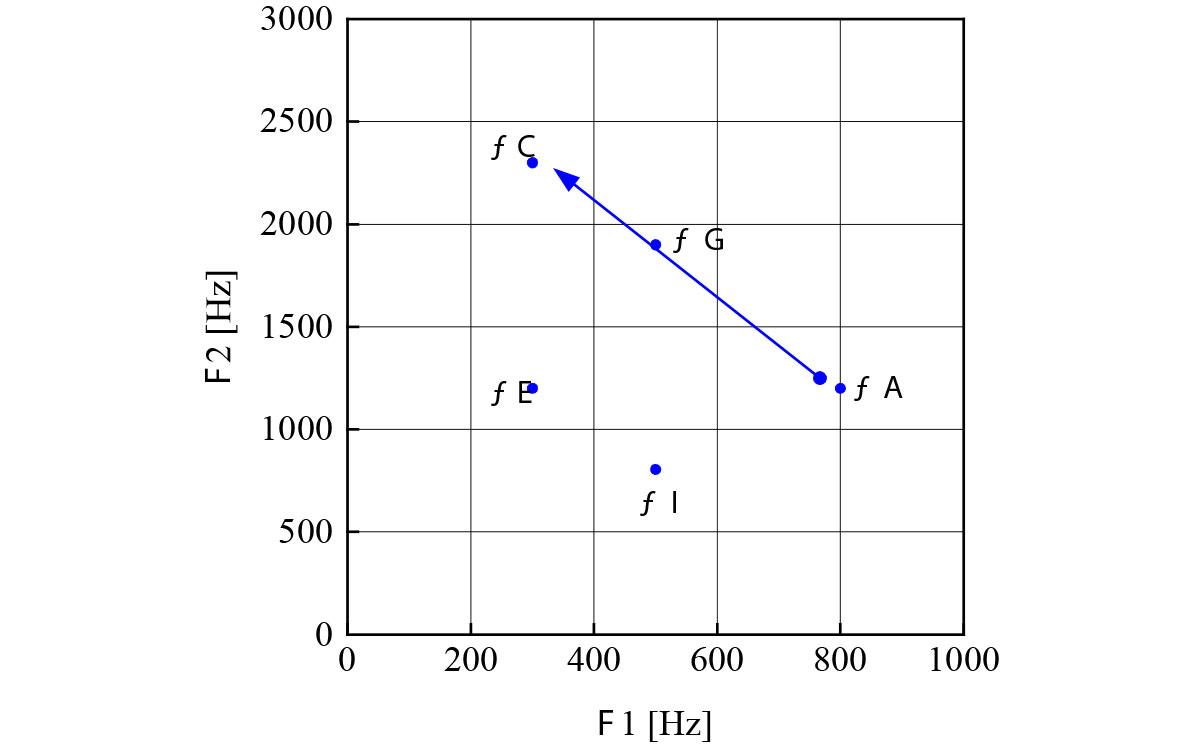

図2 5母音のフォルマント

なお、図1のスペクトログラムは、ゆらぎがまったく見られないものになっていることがおわかりいだけるでしょうか。実際に人間が発声した音声のスペクトログラムは、こんなにも整然としたものにはなりません。じつは、タネを明かせば、図1はコンピュータを使って合成した音声のスペクトログラムであり、こうした特徴が合成音声に特有の人工的な声質の理由になっています。

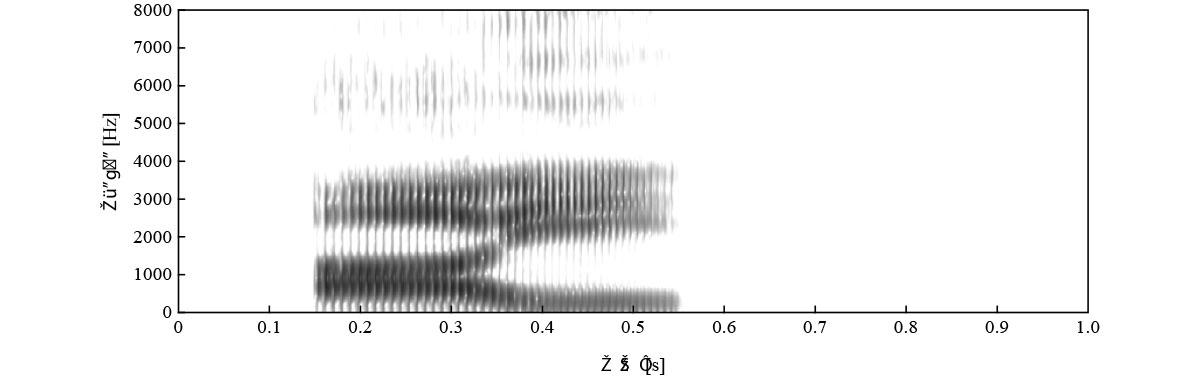

実際に人間が発声した音声のスペクトログラムは図3のようになります。これは、「アイ」と発声したときの音声のスペクトログラムです。

図3 実際に人間が発声した音声のスペクトログラム

実際に人間が発話した音声は、口腔や舌の動きに物理的な制約があるため、フォルマント遷移にはある程度の時間がかかります。そのため、スペクトログラムには、音が少しずつ変化していく「わたり」と呼ばれる区間が見られることになります。図4に示すように、F1-F2ダイアグラムをながめてみると、「ア」から「イ」に変化する際、F1は低くなり、F2は高くなっていきますが、図3の例では、こうしたフォルマント遷移に0.1秒程度の時間がかかっていることがわかります。

図4 「アイ」と発話したときのフォルマント遷移

このように、実際に人間が発話した音声は、前後の音韻がお互いに影響をおよぼすため、区切りがはっきりしません。こうした連続音声をあえて区切って発話内容を推定しなければならないことが音声認識の難しさといえるでしょう。

いずれにしても、音を可視化することで、画像から音の特徴を理解できるようにしたことが、スペクトログラムがもたらした最大の恩恵といえるでしょう。

なお、今回のレポートで説明したように、スペクトログラムから発話内容を読み取ることは「スペクトログラムリーディング」と呼ばれ、じつは、音声の専門家が身につけるべきスキルのひとつになっています。実際、言語聴覚士の国家試験では、毎年のようにスペクトログラムリーディングの問題が出題されており、そのための対策として、スペクトログラムリーディングについて教えることが養成校のカリキュラムにもなっています。